Scala & Spark Big Data Engineer

Madrid

Bluetab, an IBM Company. certificados ¡Great Place to Work & Best Work to Place! como una de las mejores compañías para trabajar.

Una compañía muy techie que nos ha llevado a ser el brazo fuerte de IBM en Data, Cloud, ML & IA y donde, para empresas clave de diversos sectores, ayudamos a acelerar y optimizar estrategias en plataformas de datos y en la nube, sacando al máximo las ventajas de su arquitectura y entornos de desarrollo.

Nos posicionamos como agnósticos de la tecnología y apostando por la innovación de los grandes fabricantes “hyperscalers”.

Estamos buscando a un/a crack del mundo del Dato (Big Data/Data Engineer), que le gusten los datos, la búsqueda minuciosa, el análisis y la tecnología. Necesitamos que tengas lo siguiente, toma nota:

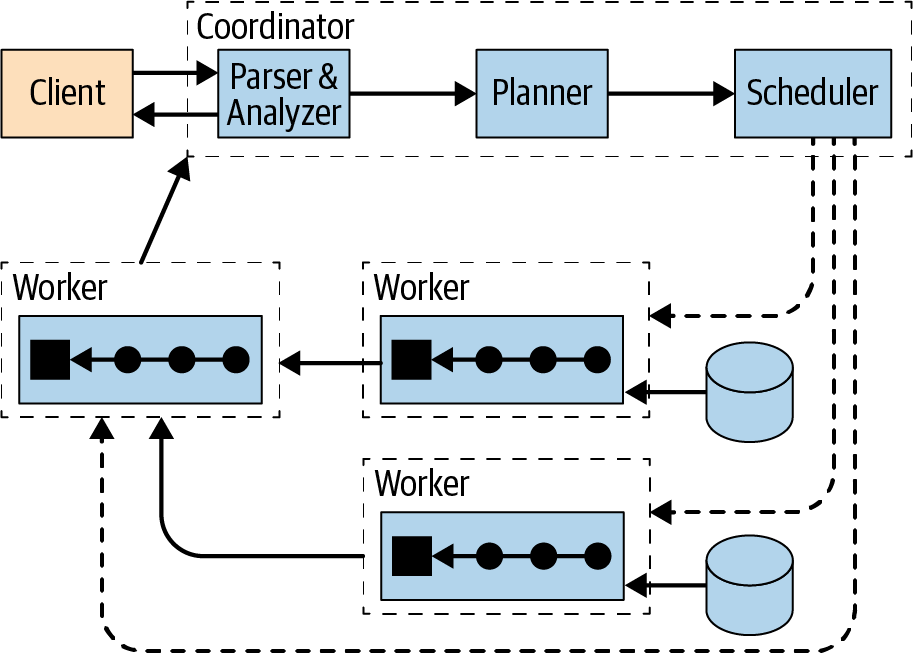

- Comprensión de cómo se comporta un sistema distribuido.

- Comprensión de la base de Hadoop: HDFS + YARN + MapReduce.

- Soltura en programación y experiencia con Scala/Spark.

- Valorable experiencia en entornos 100% Cloud, preferiblemente en AWS y/o Azure.

- Identificación y generalización de componentes reutilizables. Pruebas de despliegues en diferentes entornos.

Ahora viene lo bueno por ser bluetaber… ¿Qué ofrecemos?

- Contrato indefinido con un salario competitivo.

El salario se relaciona en función de los conocimientos técnicos detectados en el proceso y rol asignado, procurando respetar el sentido de equidad con la plantilla y siendo susceptible de mejora tras las evaluaciones continuas de desempeño. - La pregunta estrella. ¿Teletrabajo? Sí, Teletrabajo flexible. A tu entera disposición tendrás también las Oficinas ubicadas en el centro de Madrid con muy buena conexión.

- Horarios flexibles de entrada/salida, adaptado a tus necesidades personales y jornada intensiva los viernes y los meses de verano, julio y agosto.

- 23 días de vacaciones + 2 Bluetab days (nochebuena y nochevieja).

- Tarjeta restaurant como beneficio social más allá del salario.

- Seguro médico & póliza dental con una amplia cobertura también como beneficio social más allá del salario.

- Disponibilidad además de plan de retribución flexible: Transporte + Guardería.

- Formación continua gamificada a través del plan rewards, hasta 800 cursos y certificaciones oficiales.

- Además, tendrás a tu alcance el programa Career Coach para acompañarte en todo lo relativo a tu desarrollo y crecimiento dentro de Bluetab, con un sistema objetivo de evaluación continua.

- ¡Tú serás el dueño de tu crecimiento!

- Tarjeta regalo Pass por importe de 50€ en el mes de tu cumpleaños.

Consideramos que la diversidad es enriquecedora y queremos velar por la inclusión e igualdad de oportunidades, por lo que contamos con un Plan de Igualdad y un Código Ético que recoge estos principios para garantizar la no discriminación de nuestras colaboradoras y colaboradores por cuestión de raza, color, nacionalidad, origen social, edad, sexo, estado civil, orientación sexual, ideología, opiniones políticas, religión o cualquier otra condición personal, física o social.

Bluetab is an IBM Company, but will remain the hiring entity. By proceeding with this application, you understand that Bluetab will share your personal information with other IBM affiliates involved in your recruitment process, wherever these are located. More Information on how IBM protects your personal information, including the safeguards in case of cross-border data transfer, are available here:

https://www.ibm.com/careers/us-en/privacy-policy/”

Si te apasiona la tecnología y quieres disfrutar en un entorno innovador y 100% tecnológico, Bluetab, an IBM Company es tu sitio.

¡Te esperamos!

#wearehiring #bluetabanibmcompany #bluetabers

Nivel de experiencia

- Algo de responsabilidad

Sector

- Servicios y tecnologías de la información

Tipo de empleo

- Jornada completa

Funciones laborales

- Tecnología de la información

- Ingeniería

¿Quieres saber más de lo que ofrecemos y ver otros casos de éxito?

Queremos Conocerte